La matematica si trova oggi in una strana situazione: da un lato è ritenuta la scienza esatta per eccellenza, dall’altro, secondo la concezione più diffusa, quella formalistica, è ridotta a un insieme di simboli dal significato puramente convenzionale. Una tale visione non tiene conto dei limiti intrinseci dei sistemi assiomatici. Il contributo più recente in tal senso è quello di Gregory Chaitin, che ha dimostrato come perfino in aritmetica esista il caso e ha proposto una nuova e rivoluzionaria visione della matematica come scienza sperimentale. Benché ciò sollevi ovviamente molti e delicati problemi, il lavoro di Chaitin nel suo insieme dimostra inequivocabilmente come gli oggetti della matematica abbiano una qualche forma di esistenza autonoma, non interamente catturabile dai formalismi, e come la ragione e l’intuizione restino indispensabili per il loro studio.

Se un marziano sbarcasse oggi sul nostro pianeta con il compito di fare una rassegna completa dello stato delle nostre scienze, credo che niente lo imbarazzerebbe di più che tentare di far capire ai suoi simili lo strano statuto oggi correntemente attribuito alla matematica.

Da un lato infatti essa sembra essere nel momento del suo massimo fulgore, non solo per il suo sviluppo interno senza precedenti, ma anche per le straordinarie scoperte ottenute grazie alla sua applicazione alle altre scienze, tanto che si può ben dire che essa sia oggi considerata come il modello per antonomasia del rigore scientifico.  Dall’altro, con una contraddizione tanto radicale quanto apparentemente inspiegabile, essa viene in genere considerata come un costrutto meramente convenzionale: un puro «gioco» logico di assiomi e deduzioni dove conterebbe soltanto la coerenza formale intrinseca, senza riguardo ad alcunché di «esterno» fino a dubitare che i suoi «oggetti» abbiano una qualsiasi forma di realtà (e, soprattutto, del fatto che ciò abbia importanza).

Dall’altro, con una contraddizione tanto radicale quanto apparentemente inspiegabile, essa viene in genere considerata come un costrutto meramente convenzionale: un puro «gioco» logico di assiomi e deduzioni dove conterebbe soltanto la coerenza formale intrinseca, senza riguardo ad alcunché di «esterno» fino a dubitare che i suoi «oggetti» abbiano una qualsiasi forma di realtà (e, soprattutto, del fatto che ciò abbia importanza).

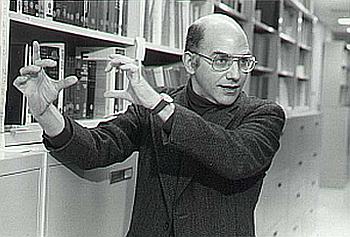

[A sinistra: Eugene Wigner (1902-1995)]

La sintesi più eloquente di questa situazione schizofrenica, che ha pesanti riflessi anche sull’insegnamento della disciplina, è forse data dal lamento del celebre fisico Eugene Wigner che si confessava incapace di comprendere «l’irragionevole efficacia della matematica nelle scienze della natura».

Tuttavia, e a prescindere da qualsiasi considerazione filosofica, dovrebbe essere evidente che, se non altro proprio perché essa «funziona» nello studio del mondo fisico, un qualche legame con la realtà, e dunque un qualche contenuto, la matematica lo deve avere. Come, dunque, si è giunti a questa situazione?

Hilbert e l’assiomatizzazione

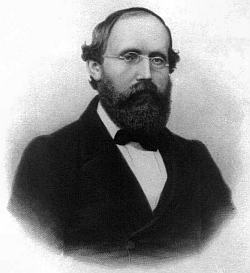

All’origine di tutto c’è un’idea che non era, di per sé, sbagliata. Si tratta del celebre programma di assiomatizzazione, voluto soprattutto da David Hilbert, al quale lavorarono molti dei più illustri matematici e logici tra la fine del XIX e l’inizio del XX secolo. Con esso si volevano individuare in maniera univoca e definitiva tutte le asserzioni che era necessario porre come indimostrate (gli «assiomi») per poterne ricavare deduttivamente, secondo regole fissate in maniera altrettanto univoca e definitiva, tutte le possibili verità matematiche (i «teoremi»).

Per assicurarsi che non potessero sussistere margini di ambiguità, tutti gli assiomi e le regole combinatorie avrebbero dovuto essere espressi attraverso simboli, in modo che a ognuno fosse associato un solo significato, chiaramente definito. In questo modo, ogni problema avrebbe potuto ricevere una soluzione altrettanto chiara e priva di ambiguità.  Tale programma non implicava di per sé la credenza nella «mancanza di significato» del sistema assiomatico così costruito. Anzi, al contrario, il sistema doveva essere modellato proprio a partire dal significato degli assiomi, in modo da rifletterlo il più chiaramente e fedelmente possibile; le ambiguità da eliminare erano infatti quelle che nascevano dall’imprecisione del linguaggio ordinario, che non consentiva di enunciarli col rigore necessario.

Tale programma non implicava di per sé la credenza nella «mancanza di significato» del sistema assiomatico così costruito. Anzi, al contrario, il sistema doveva essere modellato proprio a partire dal significato degli assiomi, in modo da rifletterlo il più chiaramente e fedelmente possibile; le ambiguità da eliminare erano infatti quelle che nascevano dall’imprecisione del linguaggio ordinario, che non consentiva di enunciarli col rigore necessario.

[A destra: David Hilbert (1862-1943)]

Molti «padri nobili» del metodo assiomatico la pensavano effettivamente così, a cominciare da Hilbert stesso. Ma a sviare rapidamente la prospettiva intervennero diversi fattori.

Innanzitutto le geometrie non euclidee. Con esse era stata posta per la prima volta in discussione l’esistenza di una geometria «vera» e si era incominciato ad affermare che in effetti si poteva parlare solo di geometrie «legittime», la legittimità risiedendo unicamente nella coerenza interna, ovvero nell’impossibilità di dedurre dagli assiomi proposizioni contraddittorie. Con il diffondersi del programma hilbertiano tale punto di vista venne generalizzato: era possibile, variando opportunamente gli assiomi, ottenere geometrie, matematiche e logiche differenti, tutte ugualmente non contraddittorie, sicché nessuna poteva dirsi «più vera» delle altre. Gli «oggetti» identificati da tali assiomi, tuttavia, erano spesso non «visualizzabili», cioè non percepibili mediante l’intuizione, ma solo attraverso il formalismo, e ciò contribuiva a spostare l’attenzione su quest’ultimo.

In secondo luogo influì il tentativo di ridurre la matematica alla logica, perseguito soprattutto da Bertrand Russell attraverso la sua rivisitazione della celebre teoria degli insiemi.

Questo tentativo non poteva che fallire(1), dato che qualsiasi nozione di insieme e di corrispondenza tra elementi di un insieme presuppone la nozione di numero che pretenderebbe invece di definire. Tuttavia, l’esistenza di un formalismo costruito con simboli logici contribuì enormemente a dare l’«impressione» contraria, tant’è vero che la (pseudo)fondazione russelliana viene ancor oggi insegnata ed è anzi ritenuta una delle più «moderne». Può sembrare strano parlare di «impressione» in questo contesto, ma nella diffusione delle idee sbagliate, anche nella scienza, i fattori psicologici giocano sempre un ruolo cruciale.

Il terzo fattore infatti fu essenzialmente psicologico: a forza di lavorare sugli aspetti formali per migliorarli sempre più si finì per perdere gradualmente di vista gli altri. In ciò aiutati peraltro dal quarto e ultimo fattore, che fu invece di natura ideologica, consistendo nella filosofia neopositivista che proprio in quegli anni prese piede. Essa trovò nell’assiomatica uno strumento potente per diffondere e giustificare le proprie idee, che consistevano essenzialmente in un radicale empirismo, il quale, per togliere legittimità alla metafisica, finiva per negare la legittimità di qualsiasi verità universale e necessaria e quindi spiegava la scienza stessa in termini meramente pragmatici e convenzionalisti.

Ciò che si perdeva di vista in tutto questo era il fatto che in realtà qualsiasi sistema assiomatico ha sempre, e necessariamente, un preciso significato, definito operativamente (nello stesso senso in cui si usa tale espressione in fisica) dalle regole combinatorie dei simboli. Tali regole, dicendo come i simboli devono essere usati, attribuiscono loro, implicitamente, ma non per questo meno realmente, determinate proprietà. Il requisito della coerenza, in apparenza puramente formale, in realtà significa proprio questo: non tutti i possibili sistemi di simboli vanno bene, perché è necessario che questi ultimi si combinino in modo da non contraddirsi a vicenda, ciò che sarebbe impossibile se fossero davvero privi di significato.

Gödel e l’incompletezza

Tuttavia, se davvero un sistema assiomatico, una volta costruito, funzionasse automaticamente sarebbe quantomeno legittimo pensare di mettere tale significato per così dire tra parentesi, per concentrarsi al massimo solo sul suo funzionamento (e, aggiungo, in tal caso sarebbe ancor più legittimo, e più logico, mettere tra parentesi l’insegnamento della matematica tout court e lasciar fare alle macchine). Il punto è che ciò non è vero. [A sinistra: Kurt Gödel (1906-1978)]

[A sinistra: Kurt Gödel (1906-1978)]

La questione si era già posta nel 1931, con il celeberrimo Teorema di Gödel. In realtà si trattava di ben undici differenti teoremi, contenuti tutti in una «memoria» dal titolo ingannevolmente modesto (Sulle proposizioni formalmente indecidibili dei Principia Mathematica e di sistemi affini), nella quale il matematico austriaco Kurt Gödel, avvalendosi degli stessi metodi usati dai fautori del programma hilbertiano, dimostrò che esso era destinato fatalmente a restare incompiuto.

Infatti, senza scampo, qualsiasi sistema assiomatico abbastanza potente da poter formalizzare almeno l’aritmetica, se è coerente, allora è incompleto.

A questo risultato Gödel pervenne tramite un procedimento complicatissimo, probabilmente il più diabolico mai escogitato da mente umana, che richiederebbe un articolo a sé per essere anche solo appena accennato.(2)

Tuttavia, ciò che in questa sede interessa è il senso della dimostrazione. Infatti, il fatto che le proposizioni gödeliane siano vere ma indecidibili significa che, evidentemente, il modo in cui noi riconosciamo la loro verità non è formalizzabile in un sistema assiomatico quale che sia, altrimenti esse non sarebbero più indecidibili. Questo dunque, come nota Evandro Agazzi, è il vero significato del Teorema suddetto, sul quale sono state dette in questi decenni le cose più diverse e spesso inverosimili. Si tratta, com’è evidente, di un risultato di primaria importanza, che ha però il limite (almeno dal nostro punto di vista) di riguardare più la filosofia che la matematica.

Da esso infatti si dimostra senz’ombra di dubbio che la nostra mente (qualsiasi cosa sia) certamente non è un computer, visto che un computer non è altro che la traduzione fisica di un sistema assiomatico. Tuttavia, le proposizioni gödeliane sono talmente particolari che, di fatto, hanno scarsissimo interesse matematico. Per cui l’atteggiamento con cui la loro scoperta è stata accolta (non senza qualche ragione) dalla stragrande maggioranza dei seguaci del programma formalista si può sintetizzare così: in teoria è una cosa importantissima, in pratica la ignoro.

Mandelbrot e la complessità

Alla fine degli anni Settanta Benoît Mandelbrot(3) scopre i frattali. Tali oggetti, come è noto, sono strutture matematiche di grande complessità, generate però a partire da regole estremamente semplici, che hanno la caratteristica di essere autosimili, ovvero di riprodurre le stesse strutture a scale differenti.

Generalmente non viene messo in luce adeguatamente il fatto che non esiste un solo tipo di frattali, ma due, caratterizzati da due tipi di autosomiglianza piuttosto diversi tra loro.

Tale autosomiglianza in entrambi i casi scaturisce dalla reiterazione di una stessa operazione che, a seconda delle circostanze, può dar luogo o alla semplice ripetizione di una stessa forma a scale diverse oppure alla generazione di forme tra loro simili (in un senso definibile rigorosamente in termini matematici), ma non identiche.

Al primo tipo appartengono strutture come la «curva di Koch», la «polvere di Cantor», il «tappeto di Sierpi_ski» e la «spugna di Menger».(4)

Per costruire una curva di Koch si comincia con un triangolo con lati di lunghezza 1. A metà di ogni lato si aggiunge un nuovo triangolo di lato pari a 1/3 di quello del triangolo precedente; lo stesso si fa per i lati liberi di ogni nuovo triangolo. All’inverso, per la polvere di Cantor si comincia con una linea e poi si elimina la terza parte di mezzo; quindi si elimina la parte centrale dei segmenti restanti, e si continua nello stesso modo. L’insieme di Cantor è la polvere di punti che rimane (esso costituisce tra l’altro un buon modello per la distribuzione degli errori in una linea di trasmissione elettronica). Un tappeto di Sierpi_ski viene costruito asportando la parte centrale, pari a un nono, della superficie di un quadrato, e poi asportando la parte centrale, pari sempre a un nono, degli otto quadrati più piccoli che rimangono; e via dicendo. L’analogo tridimensionale è la spugna di Menger: essa viene costruita con lo stesso procedimento usato per il «tappeto », solo che, ovviamente, qui si asportano cubi da un cubo anziché quadrati da un quadrato. |

Al secondo tipo appartengono invece tutti gli «attrattori strani» generati dalle dinamiche caotiche, gli «insiemi di Julia» e quella che è, a tutt’oggi, la struttura matematica più complessa che si conosca, vale a dire l’«insieme di Mandelbrot».

Tra i frattali, quelli del secondo tipo sono i più interessanti. Consideriamo per esempio la relazione x = ay che rappresenta l’equazione di una retta. La retta non può essere disegnata tutta, perché è infinita, ma sapendo che si tratta di una retta, una volta che ne abbiamo disegnato un pezzo (cioè un segmento) e abbiamo capito in che verso si estende, abbiamo in mano tutto ciò che serve: per quanto infatti possiamo prolungarla non troveremo più nessuna novità, proseguirà sempre uguale. Lo stesso avverrà con tutte le curve della matematica classica.

Le equazioni dei frattali di secondo tipo non sono in genere molto più complicate; quella dell’Insieme di Mandelbrot, per esempio, è z → z2 + c, dove c è un numero complesso.

Tuttavia, siccome le figure che si ottengono non si ripetono mai uguali, l’unico modo per studiarle è andare a vedere cosa succede costruendole materialmente: non esiste infatti alcun modo di dedurre tutte le loro proprietà dagli assiomi e quindi le relative proposizioni sono anch’esse vere, ma indecidibili, benché per ragioni diverse da quelle gödeliane.

Questo caso è anche più interessante del precedente: qui viene rivalutato non solo il ruolo della ragione, ma perfino quello della sensibilità: le figure infatti sono necessarie in quanto non possono essere eliminate senza perdita di informazione. Dunque quando abbiamo a che fare con «oggetti complessi» (nel senso tecnico del termine(5)), a quanto pare, la situazione non è molto cambiata dai tempi di Euclide.

È inutile aggiungere che ciò costituisce ben più che un indizio del fatto che agli enti matematici si debba attribuire una qualche forma di realtà oggettiva che, ben lungi dal dipendere in tutto e per tutto dal formalismo, ne costituisce, al contrario, il fondamento. Quale possa essere tale «forma di realtà» è un problema ulteriore, che esorbita dai fini di questo articolo.

Chaitin e la casualità

A questo punto si inserisce il fondamentale lavoro di Gregory Chaitin, uno dei massimi logici e matematici del nostro tempo, nonché allievo prediletto di Kurt Gödel.

Egli ha proseguito il lavoro del maestro scoprendo una forma di indecidibilità ancora più fondamentale e onnipervasiva e, fondendo tali risultati con quelli di Mandelbrot e della teoria del caos, ha delineato una nuova e rivoluzionaria visione della matematica.(6)

|

Per capire bene Chaitin è necessaria una piccola digressione. Un programma per computer non è altro che una serie di «0» e di «1» che la macchina «legge», grazie al modo in cui è costruita, come una serie di istruzioni.

Solo alcune fra tutte le possibili sequenze, però, producono un risultato sensato (cioè «si fermano», come si dice in gergo; perciò si parla di «problema dell’alt»).

Ora, è chiaro che sarebbe molto conveniente se ci fosse un metodo per riconoscerle: basterebbe infatti prendere tutte le sequenze possibili e testarle per scoprire tutti i programmi validi, compresi quelli a cui nessuno ha ancora mai pensato e magari mai penserà. Purtroppo però un tale metodo non esiste: il problema dell’alt è cioè indecidibile. Tuttavia, in linea di principio, esiste un numero di lunghezza infinita, che Chaitin ha battezzato «Omega» (Ω), esprimente la percentuale di programmi che «si fermano».

Purtroppo nemmeno Ω può essere calcolato. Se però qualche evento soprannaturale – diciamo l’arcangelo Gabriele in diretta dalla mente di Dio – ce lo rivelasse, potremmo far «girare» tutti i programmi possibili, prendere nota di quelli che via via si fermano e calcolare la loro percentuale sul totale.  Quando il calcolo dei successivi valori di Ω avesse raggiunto quello di Ω-rivelato, avremmo raggiunto la certezza che nessuno dei programmi che non si sono ancora fermati si fermerebbe più e che dunque tutti i programmi utili sono nelle nostre mani: avremmo cioè risolto il problema dell’alt! Purtroppo il procedimento richiederebbe molti miliardi di volte l’età dell’Universo per essere messo in pratica, e quindi conviene non rammaricarsi troppo dell’inconoscibilità di Ω e continuare a dar lavoro ai programmatori.

Quando il calcolo dei successivi valori di Ω avesse raggiunto quello di Ω-rivelato, avremmo raggiunto la certezza che nessuno dei programmi che non si sono ancora fermati si fermerebbe più e che dunque tutti i programmi utili sono nelle nostre mani: avremmo cioè risolto il problema dell’alt! Purtroppo il procedimento richiederebbe molti miliardi di volte l’età dell’Universo per essere messo in pratica, e quindi conviene non rammaricarsi troppo dell’inconoscibilità di Ω e continuare a dar lavoro ai programmatori.

Ciò che realmente interessa è che Chaitin sia riuscito a dimostrare che Ω è totalmente «a caso», anzi, che lo è addirittura in un senso più fondamentale di qualsiasi altro conosciuto. È interessante perché Chaitin è riuscito a collegare il fatto che una determinata equazione diofantea da lui stesso costruita (un «mostro» di 200 pagine con circa 17 000 variabili intere non negative) abbia un numero finito o infinito di soluzioni per ogni valore di un suo parametro k col fatto che il k-esimo bit di Ω sia, rispettivamente, «0» o «1».

La cosa può sembrare astrusa (e in effetti lo è), ma le sue conseguenze sono della massima importanza.

Siccome infatti Ω è «a caso», ne segue che la risposta alla domanda se l’equazione ha un numero finito o infinito di soluzioni per un certo valore di k è logicamente indipendente dalla risposta per qualsiasi altro valore.

Il che implica a sua volta, nella parole di Chaitin, che: «quali che siano gli assiomi e le dimostrazioni eventualmente applicabili per trovare la risposta valida per l’equazione diofantea con un certo valore di k, essi risulterebbero inapplicabili per la stessa equazione con un altro valore di k», sicché «casualità e imprevedibilità si hanno già nelle branche elementari della teoria dei numeri che abbiano a che fare con le equazioni diofantee ».(7)

Matematica sperimentale

Da tutto ciò Chaitin ritiene di dover trarre una conseguenza, decisamente sconvolgente per il modo in cui siamo sempre stati abituati a considerare la matematica.

Benché anche in questo caso, come già per Gödel, si abbia a che fare con proposizioni matematiche assai contorte e apparentemente irrilevanti, egli nota che ciò (insieme alla matematica frattale a cui fa altrove chiaro riferimento) dimostra che «l’incompletezza e la casualità sono naturali e pervasive»(8).

Ora, è un fatto che problemi in apparenza semplici, come per esempio quello relativo all’esistenza o meno di numeri dispari perfetti(9), hanno in realtà eluso ogni soluzione per centinaia e a volte migliaia di anni.

Egli si chiede allora: «Non potrebbe darsi che l’enunciato Non esistono numeri dispari perfetti non sia dimostrabile? Se così fosse, forse i matematici farebbero meglio ad accettarlo come assioma».(10)

Egli si rende perfettamente conto che una tale proposta «può sembrare ridicola a molti matematici, ma forse a un fisico o a un biologo non apparirebbe assurda. […] Se numerose congetture possono essere risolte facendo appello a una certa ipotesi, gli scienziati empirici prendono quell’ipotesi sul serio».(11)

Ciò soprattutto quando, come per esempio nel caso della celeberrima «ipotesi di Riemann», essa sia stata sottoposta a verifica con i calcolatori per un gran numero di casi senza trovare un solo controesempio.

|

In definitiva Chaitin propone di considerare la matematica, almeno per certi aspetti, una vera e propria scienza sperimentale!

Personalmente sono perfettamente d’accordo con lui e anzi sarei perfino più radicale, in quanto a mio parere essa lo è a tutti gli effetti e in tutte le sue parti; tale convinzione però nasce anche da altre considerazioni (e richiederebbe altre precisazioni) che in questa sede non sviluppo.

In genere, si obietta che tale approccio in matematica è molto rischioso, perché vi sono casi in cui si è trovato il controesempio quando ormai nessuno più se lo aspettava. Per esempio, la cosiddetta «congettura di Mertens», cruciale tra l’altro proprio per dimostrare l’ipotesi di Riemann, venne provata falsa dopo quasi cent’anni mostrando che una certa funzione diventava maggiore di 1 per x = -14 045 289 680 592 998 046 790 361 630 399 781 127 400 591 999 789 738 039 965 960 762, 521 505!(12)

|

Tuttavia, questo approccio è altrettanto «rischioso» anche nelle scienze naturali. In fondo, se un’ipotesi accettata in questa maniera dovesse a un certo punto rivelarsi falsa non sarebbe un dramma: si tratterebbe solo di rivedere conseguentemente quei teoremi che si basavano su di essa, proprio come accade nelle scienze naturali in occasione delle cosiddette «rivoluzioni scientifiche».

Ancor più radicale è l’ultima considerazione di Chaitin.

Infatti, come egli nota, ormai nessuno è in grado, date le loro dimensioni, di garantire la coerenza dei programmi per computer: essi vengono quindi controllati empiricamente, «cioè con la verifica di un gran numero di casi sperimentali piuttosto che con una rigorosa dimostrazione matematica».(13)

Il problema è che un programma per computer è (dimostrabilmente) equivalente a un enunciato matematico (mentre la sua esecuzione è altresì una procedura palesemente materiale, il che rende ancora più stringente l’analogia). Inoltre, i programmi per computer sono sempre più necessari nella matematica moderna e, in molti casi, per esempio in quello dei frattali, ma anche in altri più classici come quello della congettura di Mertens, addirittura indispensabili.

Quindi non solo il metodo sperimentale è già entrato di fatto nella matematica, ma alcune di quelle stesse dimostrazioni che ancora si ritengono ottenute in modo classico riposano in realtà sull’affidabilità dei programmi di calcolo e quindi, indirettamente, su una verifica di tipo sperimentale. Proprio per questa ragione i matematici non amano le dimostrazioni al computer e cercano, per quanto possibile, dopo averle ottenute, di riformularle secondo il metodo assiomatico. Ma è lecito dubitare che ciò sarà possibile ancora per molto.

È quasi superfluo sottolineare come tutto ciò deponga, in maniera ancora più decisa, a favore di una qualche forma di esistenza reale degli enti matematici e dell’importanza ineliminabile della ragione e dell’intuizione nel loro studio.

Paolo Musso

(Filosofia della Scienza – Università dell’Insubria – Varese)

Vai all’articolo in formato PDF

Note

- Intendo ovviamente il fallimento «filosofico» di questo tentativo. Il formalismo in sé funziona infatti benissimo, ma «proprio perché» presuppone (implicitamente) quei concetti che voleva eliminare.

- Cfr.: E. Agazzi, Intoduzione ai problemi dell’assiomatica, Vita e Pensiero, Milano 1962, fuori catalogo (contenente anche la traduzione di articoli originali).

- Cfr.: J. Gleick, Caos, Rizzoli, Milano 1987; G. Casati (a cura di), Il caos. Le leggi del disordine, Quaderni de Le Scienze, Milano 1991; G. Casati, Caos e predicibilità, in: Emmeciquadro n. 6. agosto 1999; F.T. Arecchi, Caos e ordine nella fisica, in: Il nuovo saggiatore, vol. 1, n. 3, Bologna 1985.

- Cfr.: J. Gleick, cit., pp. 94- 104.

- Benché non valida in assoluto (cfr.: P. Musso, Filosofia del caos, Angeli, Milano 1997, cap. 3), per quanto riguarda la complessità degli oggetti matematici si può accettare la definizione di Charles Bennett per cui essa è misurata dalla lunghezza della procedura minima capace di costruire l’oggetto a partire dalla sua descrizione minima. Nel caso dei frattali di secondo tipo la procedura minima coincide con quella massima (in quanto non esistono regolarità «comprimibili» in una istruzione più breve) e quindi la loro complessità è anch’essa massima.

- Cfr.: G. Chaitin, La casualità in aritmetica [1988], in: G. Casati (a cura di), cit., 1991, e , Randomness and complexity in pure mathematics, in: International Journal of Bifurcation and Chaos, Vol. 4, n. 1, 1994.

- G. Chaitin, cit.,1991, pp. 196-197.

- Idem.

- Un numero perfetto è un numero che risulta esattamente dalla somma dei suoi divisori escluso se stesso. Per esempio, 6 è un numero perfetto in quanto è uguale a 1 + 2 + 3.

- G. Chaitin, cit.,1991, pp. 196-197.

- Idem.

- Cfr.: K. Devlin, Dove va la matematica, Bollati Boringhieri, Torino 1994, cap. 9.

- G. Chaitin, cit., 1991, p. 197.

© Pubblicato sul n° 11 di Emmeciquadro

Gregory J. Chaitin (1947- ), logico, matematico ed esperto di computer science. Attualmente lavora presso il Thomas J. Watson Research Center dell’IBM a Yorktown Heights, New York, e collabora col celebre Santa Fe Institute per lo studio della complessità.

Gregory J. Chaitin (1947- ), logico, matematico ed esperto di computer science. Attualmente lavora presso il Thomas J. Watson Research Center dell’IBM a Yorktown Heights, New York, e collabora col celebre Santa Fe Institute per lo studio della complessità.  I problemi posti da Georg F. B. Riemann (1826-1866) [A destra] erano incentrati sulla «funzione zeta», ζ(s). Essa era stata studiata da Eulero per s intero e da Peter G.L. Dirichlet nel caso di s variabile reale.

I problemi posti da Georg F. B. Riemann (1826-1866) [A destra] erano incentrati sulla «funzione zeta», ζ(s). Essa era stata studiata da Eulero per s intero e da Peter G.L. Dirichlet nel caso di s variabile reale. La congettura di Mertens (1897) afferma che il valore assoluto della funzione di Möbius M(n) (1832) è sempre minore di √n, il che implicherebbe l’ipotesi di Riemann, che è vera per |M(n)|< A √n, (dove A è una costante di valore arbitrario).

La congettura di Mertens (1897) afferma che il valore assoluto della funzione di Möbius M(n) (1832) è sempre minore di √n, il che implicherebbe l’ipotesi di Riemann, che è vera per |M(n)|< A √n, (dove A è una costante di valore arbitrario).